Förderjahr 2024 / Projekt Call #19 / ProjektID: 7409 / Projekt: KomMKonLLM

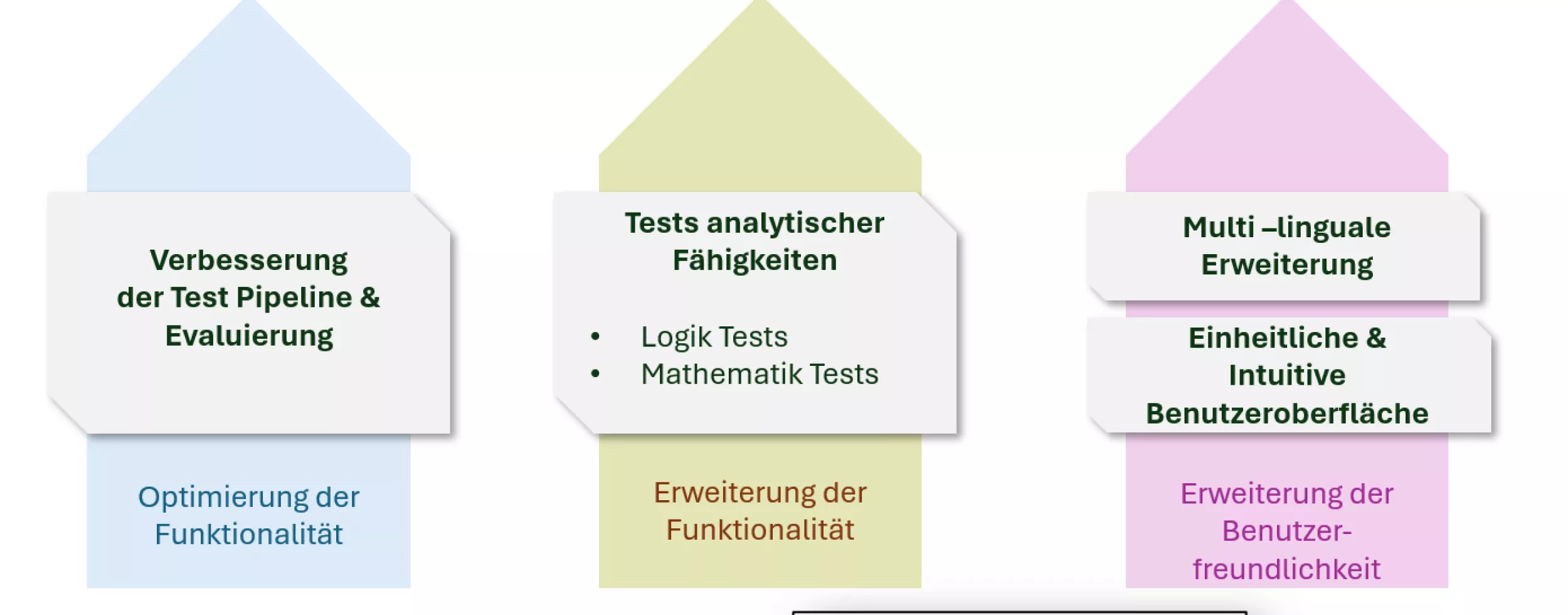

KomMKonLLM++ ist der nächste Schritt in der Entwicklung eines offenen Test-Frameworks für Large Language Models (LLMs). Tests für analytische Fähigkeiten, ein vereinheitlichtes User-Interface und eine verbesserte Testpipeline, hier die Ausblicke.

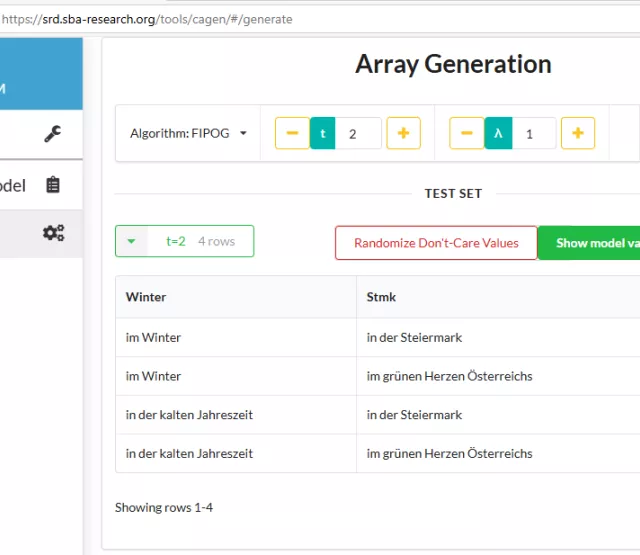

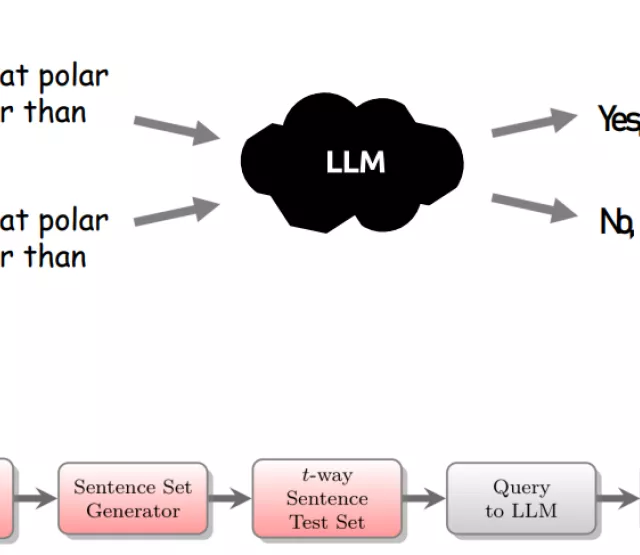

Mit KomMKonLLM++ gehen wir den nächsten logischen Schritt in der Entwicklung eines offenen Test-Frameworks für Large Language Models (LLMs) gestützt durch Methoden des kombinatorischen Testens. Während die erste Version des Tools primär auf sprachliche Konsistenztests fokussiert war, zielt die Erweiterung auf ein noch breiteres Spektrum an Fähigkeiten – insbesondere im Bereich logischer und analytischer Aufgaben.

- Erweiterung um Tests analytischer Fähigkeiten LLMs werden zunehmend in Kontexten eingesetzt, in denen mehr als nur Sprachverarbeitung gefragt ist, sondern vielmehr analytische Fähigkeiten, wie mathematischen Schlussfolgerungen und deduktives Denken, wie zum Beispiel bei der Interpretation strukturierter Informationen, wie Tabellen oder Abrechnungen. Genau hier setzt KomMKonLLM++ an: Das Framework wird um neue Logik- und Mathematik Tests erweitert. So werden beispielsweise klassische Ableitungsregeln der Aussagen- und Prädikatenlogik systematisch überprüfen. Durch die Integration logisch äquivalenter Aussagen lassen sich semantische Konsistenztests erzeugen, die LLMs auf ihre Fähigkeit zur korrekten Ableitung und Interpretation prüfen. Logische Äquivalenzen lassen sich auch dafür verwenden semantisch äquivalente Aussagen aus einer gegebenen abzuleiten. Dies stellt eine natürliche Erweiterung unserer bisherigen Konsistenztests dar.

- Einheitliches und intuitiveres User Interface Ein wichtiger Fokus liegt auf der Bedienbarkeit. Die ursprüngliche Version richtete sich vor allem an technisch versierte Nutzer:innen. KomMKonLLM++ wird nun ein vollständig überarbeitetes User Interface erhalten: klarer strukturiert, visuell zugänglicher und mit konsistentem Design. Besonders die Eingabe- und Auswertungsbereiche werden vereinheitlicht, sodass Nutzer:innen Tests effizienter erstellen, anpassen und interpretieren können.

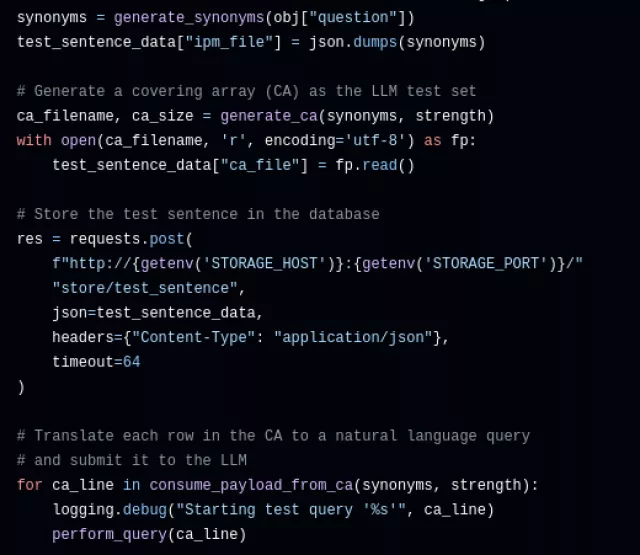

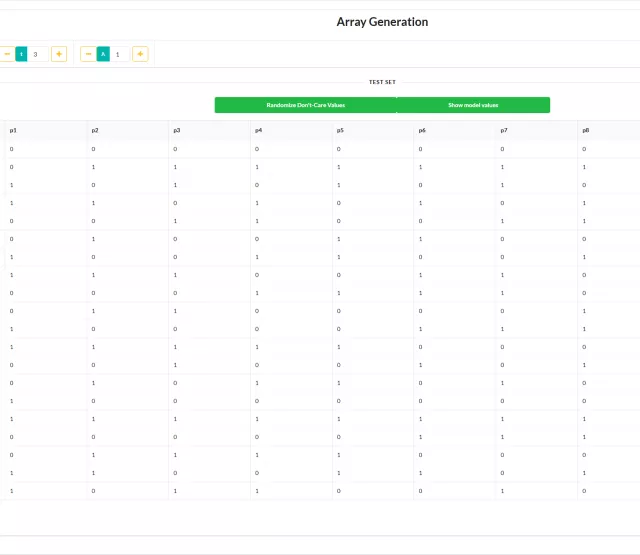

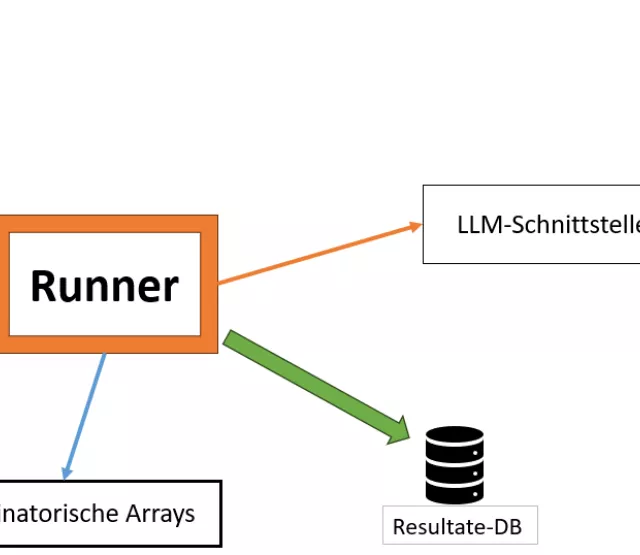

- Verbesserung der Test-Pipeline

Die interne Testpipeline kann auf folgende Weisen verbessert und erweitert werden:

- Synonyme müssen nicht aus externen Bibliotheken importiert werden, sondern können direkt vom getesteten LLM selbst generiert werden. Das stellt einen kontextsensitiveren und vielseitigeren Zugang dar.

- Eine automatische Vorvalidierung der abgeleiteten Tests durch das LLM selbst soll semantische Kohärenz sicherzustellen, und die Qualität der Tests erhöhen.

- Die Evaluierung des Outputs kann verbessert werden, etwa um differenziertere Rückmeldungen zu erlauben, etwa hinsichtlich logischer Richtigkeit oder sprachlicher Konsistenz.

KomMKonLLM++ ist mehr als ein technisches Upgrade. Es ist ein Schritt in Richtung eines umfassenden, offenen Frameworks für LLM-Evaluation, mit einem Fokus auf Korrektheits- und Konsistenztests. Mit vielseitigen Erweiterungsmöglichkeiten wird es es zum zentralen Werkzeug für einen verantwortungsvollen Einsatz von KI.

Ludwig Kampel

Ludwig holds a master’s degree in Technical Mathematics with focus on discrete mathematics, and a PhD in Computer Science, with a focus on combinatorial designs and their application for software testing, both from the TU Wien.

Over the past years, Ludwig built up the Combinatorial Algorithms, Arrays and Optimization team (CALGO team) within the MATRIS Research Group.

In his spare time Ludwig enjoys committing himself to the activities of the Association for Advancing Applications of Mathematics (AAAM) (https://www.aaam.top) and playing a type of soft-hockey (a.k.a. Bouncer-Ball).