Förderjahr 2020 / Project Call #15 / ProjektID: 5305 / Projekt: GAB: Game-Assisted Brainstorming

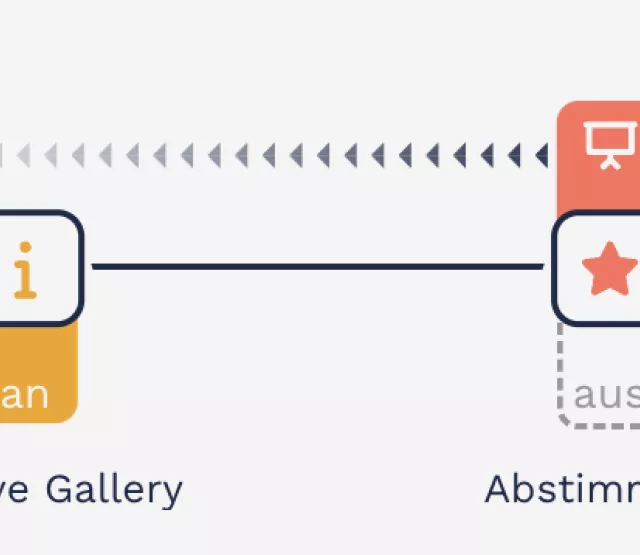

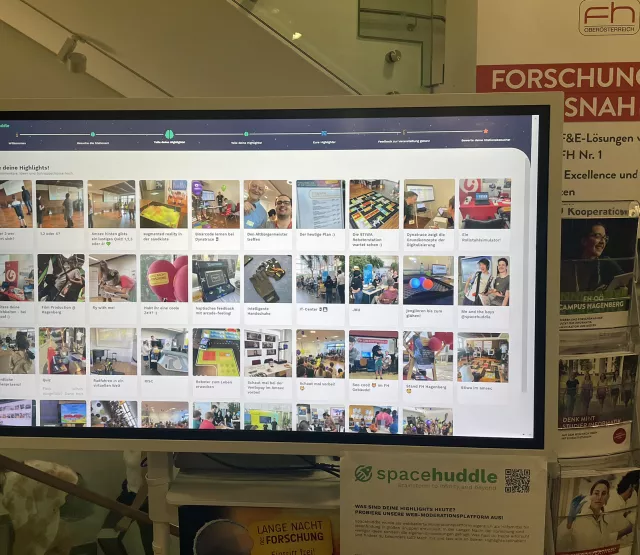

Die Grundidee bei Game-Assisted Brainstorming war immer, dass eine größere Anzahl von Menschen kreative Ideen spielerisch gemeinsam entwickeln können. Dafür waren kleine Web-Module für die Ideenabgabe, Kategorisierung und Bewertung notwendig. Mit dem entwickelten Prototypen Spacehuddle war dies bereits Anfang 2022 grundsätzlich möglich, jedoch fehlte noch ein großer Test unter realen Bedingungen mit mehreren gleichzeitigen Personen. Spacehuddle wurde zwar bereits in mehreren Lehrveranstaltungen und in vielen Meetings getestet, aber diese Einsätze waren trotzdem etwas limitiert. Außerdem wollten wir das Werkzeug gegenüber bestehenden digitalen Werkzeugen testen.

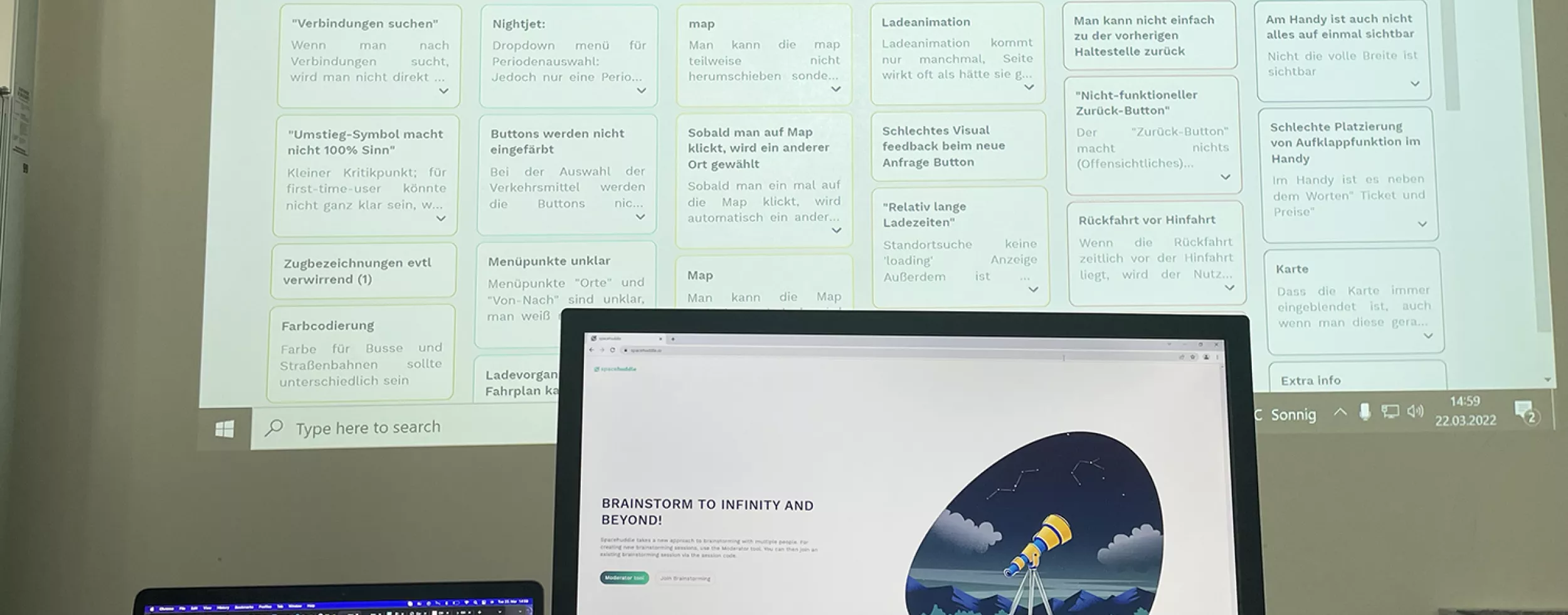

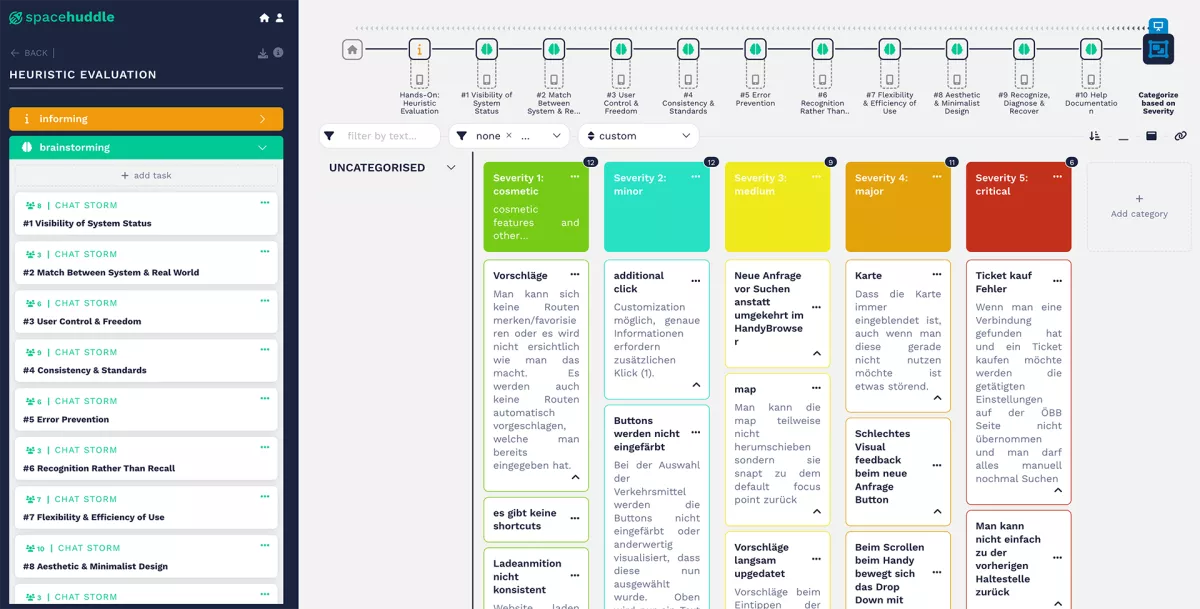

Im Sommersemester 2022 war es dann so weit und ein passender, realer Einsatz wurde in der Lehrveranstaltung "Usability and Interaction Design" gefunden: Spacehuddle sollte als kollaboratives Werkzeug bei einer heuristischen Evaluierung mit 22 Teilnehmer*innen eingesetzt werden. Eine heuristische Evaluierung verwendet bekanntlich etablierte Richtlinien, um Usability-Probleme von einer Anwendung zu erkennen bzw. auch gemeinsam zu bewerten. Diese Art der Evaluierung wird meist mit mehreren Personen gemacht, um persönliche Präferenzen und Befindlichkeiten auszuschließen. In diesem Fall sollte die ÖBB-Fahrplan-Applikation von Studierenden in der Lehrveranstaltung evaluiert werden. Um Spacehuddle mit anderen Werkzeugen zu vergleichen, wurden in zwei weiteren Testgruppen jeweils die Werkzeuge Miro bzw. Microsoft Excel eingesetzt. Die drei Testgruppen wurden dann bei der Arbeit beobachtet und es wurden Fragebögen von den Moderator*innen und Evaluator*innen ausgefüllt.

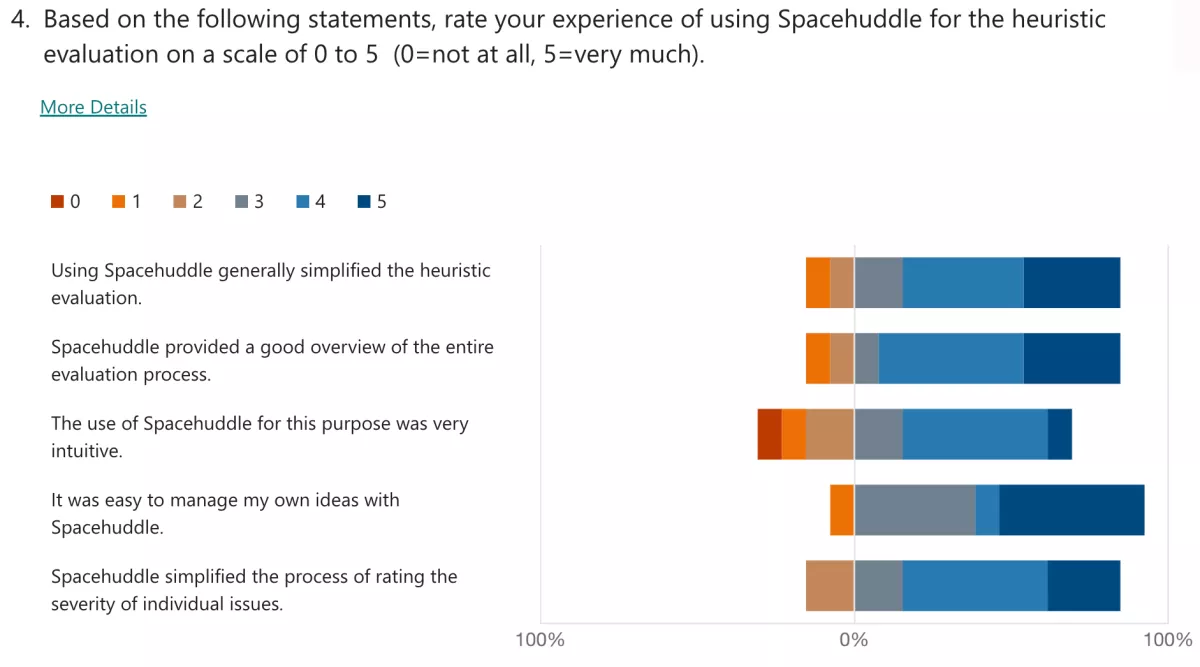

Die Ergebnisse waren für uns teilweise überraschend: klar wurden von Spacehuddle auch einige Usability-Probleme erkannt, v.a. weil wir die Nutzung am Tablet für die Moderation nicht so wirklich vorgesehen haben (Drag-und-Drop-Fehler mit Touch statt Mouse war die größte Schwierigkeit), aber Spacehuddle hat in mehreren Bereichen besser abgeschnitten als Miro und Excel. Das ist nicht nur deshalb überraschend, weil Miro und Excel weit mehr Funktionalität haben und bei den Testgruppen viel besser bekannt waren, sondern weil Spacehuddle für diesen bestimmten Zweck eigentlich nicht entwickelt wurde. Vor allem punktete Spacehuddle bei der Geschwindigkeit: die Gruppe mit Spacehuddle als Werkzeug war viel früher fertig, die Anzahl und Qualität der Beiträge sind aber keinesfalls geringer als in den anderen Testgruppen. Die Evaluierungsbeiträge mit entsprechender Kategorisierung von der Spacehuddle-Gruppe können online von Interessierten begutachtet werden.

Klar reicht der Test trotz ausführlicher Analyse nicht für einen eindeutigen Beweis, dass Spacehuddle besser geeignet ist für eine heuristische Evaluierung als die anderen Werkzeuge, es zeigt sich jedoch für diesen Anwendungsfall jedenfalls gewappnet. Ein Konferenzbeitrag mit diesen vorläufigen Ergebnissen ist auch in Arbeit und wir freuen uns auf den nächsten Einsatz für Spacehuddle!