Förderjahr 2020 / Stipendien Call #15 / ProjektID: 5110 / Projekt: Künstliche Intelligenz: Eine grund- und datenschutzrechtliche Untersuchung

Adverserial Machine Learning

KI-Systeme werden zunehmend in sicherheitskritischen Anwendungen, wie etwa autnomen Fahrzeugen, Robotern oder Medizinprodukten, eingesetzt.[1] In diesen Anwendungsfeldern müssen KI-Systeme zur Sicherheit der Betroffenen aber nicht nur zuverlässige Vorhersagen treffen, sondern auch gegenüber Angriffen und Manipulationen robust sein.[2] Aktuelle Verfahren zur Entwicklung von KI-Systemen sind jedoch häufig leicht angreifbar und können durch adaptierte Eingaben auf verschiedenen Ebenen getäuscht werden.

So kann beispielsweise der Lernvorgang in der Trainingsphase gestört werden (Poisoning); Vorhersagen beim Einsatz des KI-Systems sind verfälschbar (Evasion) und vertrauliche Informationen können aus fertig trainierten KI-Modellen extrahiert werden (Model Stealing). Im vorliegenden Forschungsprojekt wird vorgeschlagen diese Problematik als „Fragilität“ von KI-Systemen zu bezeichnen.

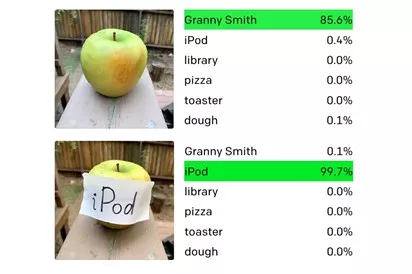

Abbildung: Dieses Beispiel zeigt, wie leicht ein KI-System, dass dem Stand von Wissenschaft und Forschung entspricht, angegriffen werden kann. Sogar handschriftliche Notizzettel reichen aus um mit einem sog „typographic attack“ das Ergebnis eines Classifier-Systems mit hoher Confidence zu verfälschen.[4]

Die Anfälligkeit von KI-Systemen gegenüber solchen „adverserial examples“ (bzw „wild patterns“) sowie die Entwicklung geeigneter Gegenmaßnahmen ist (mittlerweile) auch Gegenstand des wissenschaftlichen Diskurses geworden. Denn, obwohl KI-Systeme bereits in viele Produkte integriert werden, ist Informationssicherheit von KI-Systemen als wissenschaftliches Feld noch verhältnismäßig jung: Erst seit Mitte der 2000er Jahre – mit dem Aufkommen von Spam-Filtern – wird die Informationssicherheit von KI wissenschaftlich untersucht. Hierbei ist insb die Arbeit Biggio/Roli hervorzuheben, die das Feld in einer übersichtlichen Zusammenschau seit ihren Anfängen darstellt.[4]

[1] Vgl zu verschiedenen Risiken auch Europäische Kommission, Impact Assessment of Regulatory Requirements for Artificial Intelligence in Europe, SWD(2021) 84 final, 58.

[2] Müller-Quade et al, WHITEPAPER. AG IT-Sicherheit, Privacy, Recht und Ethik, 1.

[3] Vgl allgemein Müller-Quade et al, WHITEPAPER. AG IT-Sicherheit, Privacy, Recht und Ethik, 17.

[4] Goh et al, Multimodal Neurons in Artificial Neural Networks, 4.3.2021.

[5] Biggio/Roli, Wild Patterns: Ten Years After the Rise of Adversarial Machine Learning.